bert

输入:

1

2

3

Token Embedding:词向量

Segment Embedding:句子特征的嵌入

Position Embedding:词位置特征

输出:

1

2

MLM任务:通过其他的词预测杯掩盖的词

NSP任务:判断句子B是否为句子A的下一句

特点:

1

2

3

4

真正的双向

动态表征

并行运算能力

易于迁移学习

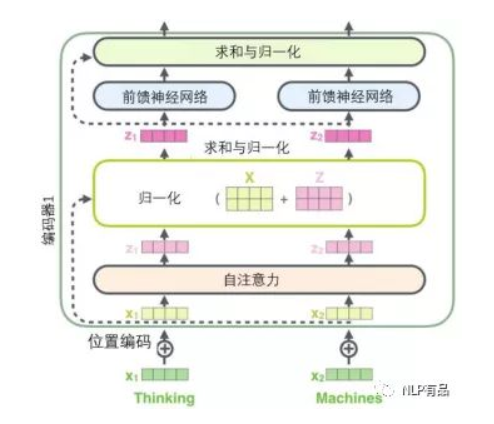

结构:

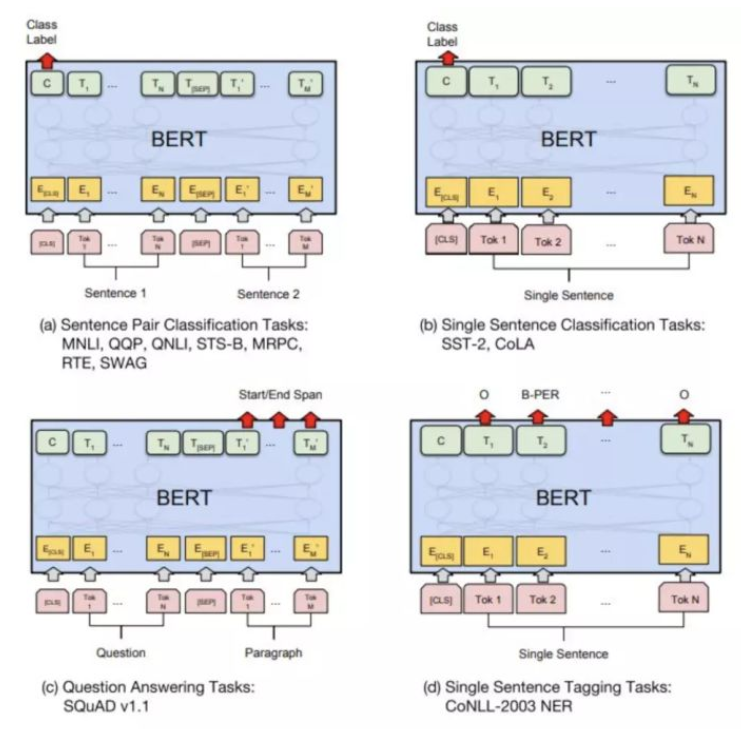

使用:

缺点:

1

2

预训练任务带有mask,但是下游任务mask没有出现

独立性假设:bert假设不同的mask之间相互独立,忽略了mask之间的相关性

XLNET

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

RoBERTa

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

ALBERT

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

ELECTRA

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

ERNIE

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

BERT-WWM

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

SpanBERT

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

TinyBERT

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1

DistillBERT

输入:

1

输出:

1

特点:

1

结构:

使用:

缺点:

1